Co za warsztat?

Czy znjąc czynniki determinujące budowanie zaufania ludzi do AI czy robotów, możemy zakładać, szacować, które z nich są dla poszczególnych grup odbiorców mniej lub bardziej istotne? Takie ćwiczenie zrealizowałam podczas konferencji FARI Brussels Conference 2025, w ramach warsztatu: Building Human–AI–Robot Cooperation.

Co się okazało?

- Uczestnicy dostrzegli oczywiście bardzo duży potencjał AI/robotyki, jednak ten potencjał jest możliwy tylko przy: jasnym zarządzaniu ryzykiem i dobrej regulacji.

- Kompetencje nie są problemem – problemem jest etyka, odpowiedzialność i przejrzystość.

- Najbardziej wrażliwi interesariusze (np. obywatele, pacjenci) mają niestety najmniejszą kontrolę nad danymi. To jest klasyczne przesunięcie władzy w kierunku instytucji i firm technologicznych.

- W każdej grupie pojawia się motyw „kompromis między bezpieczeństwem a przejrzystością”, wskazujący, że im bardziej system krytyczny i bezpieczny, tym może mieć większą tendencję do mniejszej przejrzystości.

- Cyberzagrożenia są wspólnym zagrożeniem dostrzeżonym we wszystkich grupach.

Ale po kolei, jak przebiegała nasza praca?

Uczestnicy warsztatu, losowali 3 case study:

- Unia Europejska wprowadza system, który umożliwia lekarzom w dowolnym kraju członkowskim dostęp do elektronicznej dokumentacji pacjenta. System oparty jest na sztucznej inteligencji, która automatycznie tłumaczy dane medyczne, rozpoznaje wzorce chorób i sugeruje możliwe terapie.

- Sieć logistyczna w UE wdraża autonomiczne drony i roboty magazynowe do transportu i obsługi przesyłek pomiędzy krajami sąsiedzkimi. System zarządzany jest przez platformę AI, która optymalizuje trasy, czas dostaw i zużycie energii.

- Miasta położone na granicy między sąsiednimi krajami współpracują w zakresie systemu zarządzania energią odnawialną. Algorytmy sztucznej inteligencji analizują dane z sieci energetycznych po obu stronach granicy, prognozują zapotrzebowanie i samodzielnie równoważą nadwyżki i niedobory.

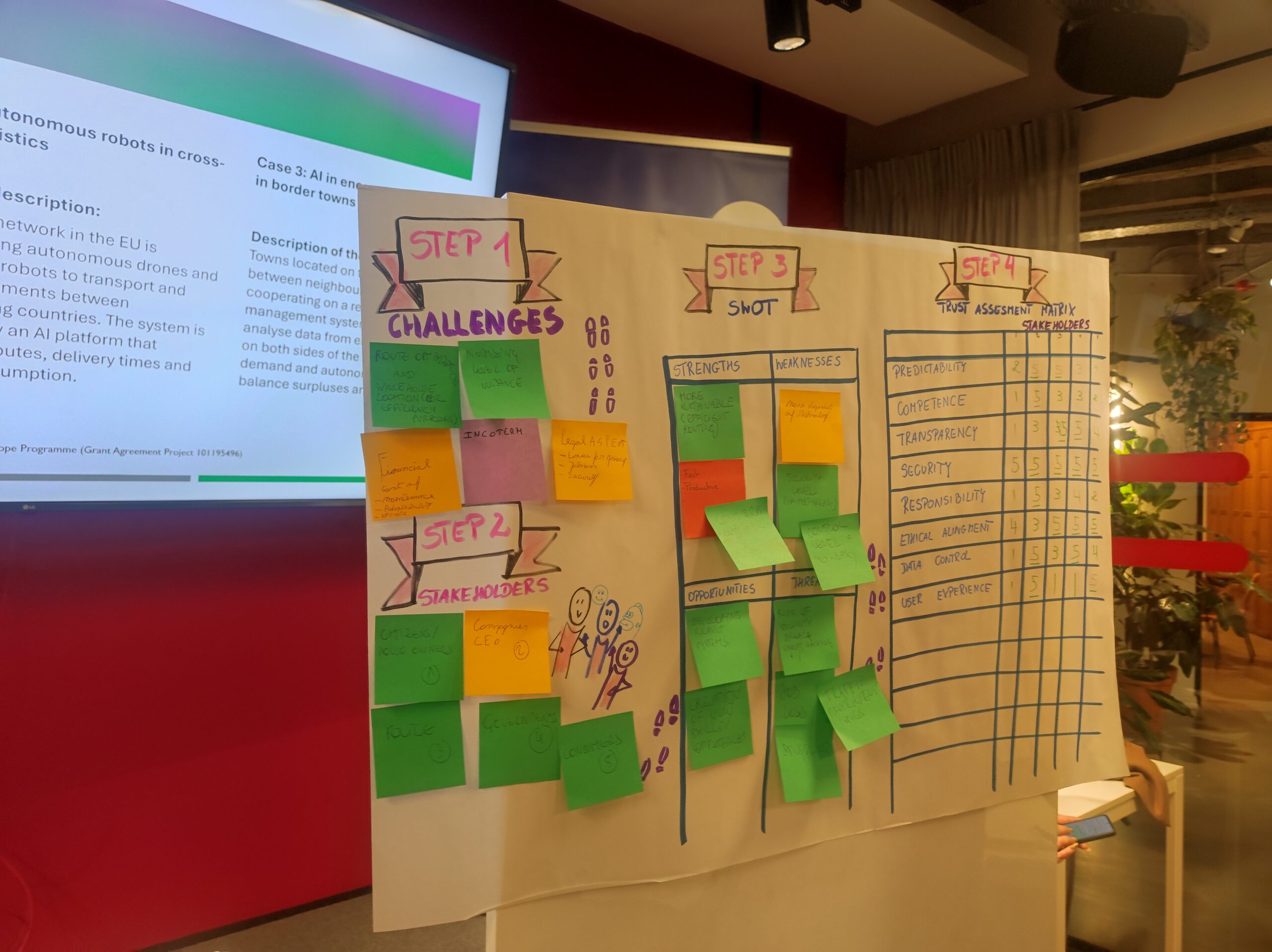

Analizując te wykreowane przekłady wykorzystania interpretacyjnych, międzygranicznych systemów opartych na AI, mieli za zadanie zidentyfikowanie głównych wyzwań związanych z takimi wdrożeniami oraz głównych interesariuszy. Następnie przygotowywali SWOT oraz Trust Assessment Matrix. Matrix to narzędzie, służące do ocenienia poziomu znaczenia, dla poszczególnych interesariuszy, predefiniowanych czynników determinujących zaufanie: takich jak np. przewidywalność, transparentność, bezpieczeństwo, odpowiedzialność za błędy itp.

Wyniki SWOT

Jako mocne strony rozwiązań najczęściej wskazywali:

- Efektywność / optymalizacja procesów (energia, zdrowie, logistyka).

- Większa dostępność danych i informacja w czasie rzeczywistym.

- Redukcja kosztów i marnotrawstwa.

- Większa odporność i stabilność systemów.

- Wsparcie decyzji (np. medycznych lub operacyjnych).

Słabości - w wielu grupach pojawiają się te same obawy

- Brak transparentności systemu / black box AI.

- Zależność od danych oraz ryzyko ich złej jakości.

- Wysokie koszty wdrożenia.

- Nierówny dostęp, brak interoperacyjności.

- Wiele interesariuszy = trudności z koordynacją.

- Brak jasnych zasad odpowiedzialności.

- Największą słabością jest nieprzejrzystość systemów AI oraz problemy z zarządzaniem danymi. To prowadzi także do erozji zaufania.

Grupy dostrzegały szanse w:

- Lepszym planowaniu (np. energii, zdrowia).

- Współpracy / integracji danych / interoperacyjności europejskiej.

- Tworzeniu nowych usług i modeli biznesowych.

- Stabilności systemów krytycznych.

- Poprawie jakości usług publicznych.

- Rozwóju AI i robotyki wspierającej człowieka.

Zdefiniowane zagrożenia, powtarzały się u wszystkich grup:

- Cyberataki i naruszenia danych (dominujący motyw).

- Ataki na infrastrukturę krytyczną / punkty podatności.

- Błędy danych → błędne decyzje.

- Wysokie koszty wdrożeń / ryzyko nierówności.

- Brak akceptacji społecznej.

- Nieetyczne wykorzystanie technologii.

Można zatem zauważyć, że zagrożenia koncentrują się wokół bezpieczeństwa i odpowiedzialności systemowej – co bezpośrednio wpływa na poziom zaufania.

TRUST ASSESSMENT MATRIX – analiza międzygrupowa

Macierz zaufania pojawia się w każdej z 5 grup. Każda grupa oceniała w skali od 1 do 5, jak istotny, w budowaniu zaufania d systemu, jest wskazany czynnik dla konkretnej grupy interesariuszy (np. mieszkańców, firmy, regulatorów, lekarzy, policję, itp.)

Predefiniowano 8 kategorii:

Kategorie:

- Przewidywalność( Predictability)

- Kompetencja (Competence)

- Przejrzystość (Transparency)

- Bezpieczeństwo (Security)

- Odpowiedzialność (Responsibility)

- Zgodność z zasadami etycznymi (Ethical Alignment)

- Kontrola danych (Data Control)

- Doświadczenie użytkownika (User Experience)

Oczywiście wyniki przedstawione przez poszczególne grupy różniły się od siebie, nawet gdy analizowany był ten sam study case. Można jednak dostrzec wspólne trendy w przygotowanych przez uczestników analizach:

1. Przejrzystość

Najczęściej oceniana była nisko, jako czynnik, który nie ma wysokiego priorytetu w budowaniu zaufania.

2. Kontrola danych

W wielu grupach bardzo zróżnicowana – często oceniana nisko dla konsumentów/obywateli.

3. godność z zasadami etycznymi

Wskazywany jako mało istotny czynnik, szczególnie dla dużych firm/AI developerów.

4. Bezpieczeństwo

W kilku grupach oceniona wysoko, szczególnie dla operatorów np. energii, często dla instytucji publicznych lub dużych firm technologicznych.

5. Kompetencje

Wysoko oceniana zwłaszcza dla: firm technologicznych, operatorów infrastruktury, lekarzy / instytucji zdrowia (str. 3).

6. Przewidywalność

Często określana, jako istotna z wysokimi notami, zwłaszcza gdy chodzi o ustalone role (np. regulator, operator systemu).

Analizuąc przygotowane matryce można dostrzec także, że grupy spójnie uznały, że

- Interesariusze tacy jak Instytucje publiczne / regulatorzy, wysoko cenić będą bezpieczeństwo i przewidywalność, a niżej przejrzystość i zgodność z zasadami etycznymi

- Dla firm; wysokie znaczenia będą mieć kompetencje, niska natomiast przejrzystość i zgodność z zasadami etycznymi

- Konsumenci / obywatele, uczestnicy warsztatów przewidują, że dla nich kontrola danych – będzie miała niskie znaczenie, za to będą wyżej cenić wpływ doświadczenie użytkownika (user experience)na budowę zaufania.

Myślę, że można pokusić się o następujące podsumowanie:

- Uczestnicy dostrzegli oczywiście bardzo duży potencjał AI/robotyki, jednak ten potencjał jest możliwy tylko przy: jasnym zarządzaniu ryzykiem i dobrej regulacji.

- Kompetencje nie są problemem – problemem jest etyka, odpowiedzialność i przejrzystość.

- Najbardziej wrażliwi interesariusze (np. obywatele, pacjenci) mają niestety najmniejszą kontrolę nad danymi. To jest klasyczne przesunięcie władzy w kierunku instytucji i firm technologicznych.

- W każdej grupie pojawia się motyw „kompromis między bezpieczeństwem a przejrzystością”, wskazujący, że im bardziej system krytyczny i bezpieczny, tym może mieć większą tendencję do mniejszej przejrzystości.

- Cyberzagrożenia są wspólnym zagrożeniem dostrzeżonym we wszystkich grupach.

Zdjęcie: Katja Anokhina na Unsplash.